- HOME

- 刊行物のご案内

- 心理学ワールド

- 95号 ヒトのアタッチメント再考

- OpenFaceを用いた表情分析

こころの測り方

OpenFaceを用いた表情分析

難波 修史(なんば しゅうし)

Profile─難波 修史

専門は実験心理学。主要論文にNamba, S. et al. (2021). Distinct temporal features of genuine and deliberate facial expressions of surprise. Scientific Reports, 11(1),1-10.など。

表情は,思考,知覚,感情,計画などの心的状態を反映しうる媒体であり,そのセンシング技術はこころの測定に利用可能な指標を拡張します。ここでは,表情運動に関する情報を手軽に取得することができるOpenFaceを紹介します。

OpenFaceとは

OpenFaceとはTadas BaltrušaitisがMultiComp Labとの共同研究で開発した表情分析用のアプリケーションです1。OpenFaceでは任意の顔画像・動画から,①表情上に付与された68個の特徴点(以下ランドマーク)におけるx・y軸の動き,②顔の向き,③Action Unit(AU)と呼ばれる表情運動要素2,④視線,の推定値を取得することができます。震えあがるほど便利ですね。

OpenFaceの長所

自動表情運動検出システムであるOpenFaceの長所は,2点あります。1点はその使いやすさです。(Windows環境に限り)ユーザーが画面上で視覚的にとらえて操作できる便利なアプリケーション(OpenFaceOffline.exe)が存在しているので,プログラミングに親しみのない人でもexeファイルを実行すれば直観的な操作で表情の分析が可能となります。さらに,Dockerと呼ばれるプラットフォームを活用すれば,MacだろうとLinuxだろうと関係なく,どのOSでも気軽に利用することができます。詳しい使用方法は本記事末尾に記載しております「OpenFaceの使い方」をご覧ください。Wikiページのリンクがあります。まぁそのリンクがあるってだけなんですけどね。

2点目は顔・表情の動画像から多様な情報を簡便に抽出することができる点です。動画の解析においてはフレームごとの画像から情報を取得するので,フレームの展開に応じた時系列・動的情報の検討が可能となります。その利点は,近年の表情のダイナミクスに注目した研究で積極的に活用されています。例えば,Sowdenらは感情喚起映像を用いた自然な表情と意図的に作成された表情の動画から,OpenFaceによってランドマークの運動ベクトルを抽出し,感情・部位ごとで表情運動の速度が異なることを明らかにしました3。Perusquía–Hernándezらは,自然な笑顔と意図的な笑顔を対象としてOpenFaceによって抽出されるAUの時系列情報と遠隔筋電測定装置から取得した情報を組み合わせた特徴量により眼輪筋および大頬骨筋活動の検出可能性が向上したことで,自然な笑顔と意図的な笑顔を弁別できることを報告しています4。動画から,表情上の特徴点を手動で付置したり,AUのような各表情筋の生起を手動で記述したりすることによって時系列データを取得することは,非常に大変で骨が折れる作業です。OpenFaceのようなシステムは,そうした作業を自動化させることで研究の速度と可能性を飛躍的に増進してくれるアプリケーションであるといえるでしょう。

OpenFaceは,画像・映像に含まれた情報から人間の顔を検出して切り出すFace detection機能も搭載しています。また,切り出された顔表情の映像はできるだけ真正面を向くよう補正されているため,多少の体動による影響は統制されることが期待されます。近年の研究では,表情刺激作成の文脈で顔のみを感情反応映像から抽出するために,OpenFaceが活用されるケースが報告されています5。映像から顔のみを抽出したいというニーズにもしっかりこたえてくれる,ナイスなアプリケーションですね。

ちなみに自動表情運動検出システムは,OpenFace以外にも存在します(例:AFAR toolbox:https://github.com/AffectAnalysisGroup/AFARtoolbox,Py-feat:https://py-feat.org/content/intro.html)。そこで,現段階の学習済みシステムの中でもっとも人による表情記述に近い成績を出すシステムはどれかを,我々の研究チームで調べました。その結果,YouTubeの映像,会話場面など様々な性質を持つ表情刺激に対して,表情要素であるAUの検出精度がもっとも高くなった(人の符号化に近い予測を行った)のはOpenFaceでした6。2021年段階で,心理学者が表情運動を記録したい場合にはOpenFaceが最適な選択肢となるでしょう。

OpenFaceの短所

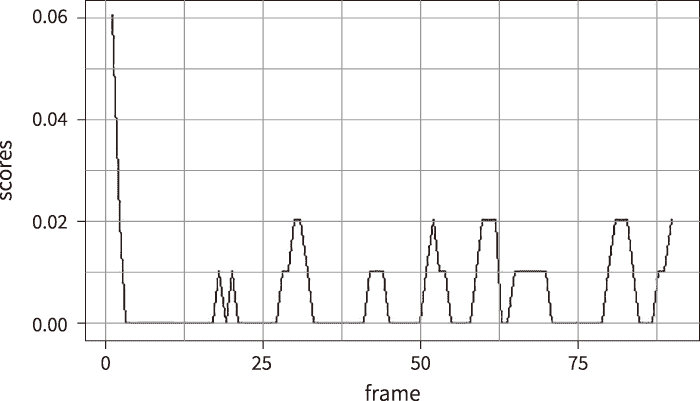

OpenFaceを適用する際に,どういった課題があるかを認識することは重要です。OpenFaceに限らず,現状の自動表情運動検出システムは推定の際に確率的なノイズが含まれてしまいます。例えば,図1には男性の真顔静止画像を3秒間に引き延ばしただけの動画を対象として,それをOpenFaceに解析させた結果の一部をプロットしてみました。AUの種類は現状無視していただいて構いません。この例は,「写真を3秒呈示させたもの」なので表情上に動きがみられるはずがないのですが,機械による出力では,①分析開始段階で大きなノイズが生じている,②微細な表情運動の(誤)検出が生じている,ということが視覚的に見てとれます。y軸を見ればその誤差は充分小さいともいえるのですが,その誤差の大きさは対象となる顔表情の性質に依存します。この他にも学習に用いたデータに依存したバイアスが指摘されています。例えば,笑顔の基本である口角の上昇を推定する際には上唇の上昇やえくぼを作る動きとの共起が誤検出されやすいことや4,内眉の上昇を推定する際に外眉上昇との共起が誤検出されやすいこと6などが知られています。こうした微細なノイズや表情運動の共起バイアスが存在していることから,完全な表情運動の自動記述には未だ至れていないことがわかります。

ただし,この結果は動画解析用の処理が推定システムの中に入っていることに注意する。

また,OpenFaceは68個分のランドマークを表情画像から推定し,その情報をベースとして顔の向きや表情筋運動の推定を行います。そのため顔の緊張や皺を作る動きといったx・y軸の運動で表現するのが難しい情報は,原理的に推定が難しくなります。そうした表情運動を推定したい際には,ランドマークベースではなく画像から直接表情運動を推定するようなシステム(例:AFAR toolbox)が適している場合もあります5。システムによって得手・不得手があるので,目的に沿ってしっかり使い分けていきましょう。

OpenFaceの使い方

OpenFaceは学術・非商用目的であれば,表情の動画像から①表情ランドマーク,②顔の向き,③AU,④視線,といった多様な情報を誰でも,簡単に取得することができます。インストール方法・使用方法などに関しても,開発者によるWikiページが充実しているので用途に応じてご参照いただければと存じます(https://github.com/TadasBaltrusaitis/OpenFace/wiki)。また,拙ブログにてOSに依存しないDockerを用いたOpenFaceの使い方を紹介していますので,ご覧ください(https://susishushi.github.io/my_blog/post/of/)。表情の分析を検討してみたい方は,ぜひ,OpenFaceを活用してみてください。

文献

- 1.Baltrusaitis, T., Zadeh, A., Lim, Y. C., & Morency, L. P. (2018, May). Openface 2.0: Facial behavior analysis toolkit. In 2018 13th IEEE international conference on automatic face & gesture recognition (FG 2018) (pp.59-66). IEEE.

- 2.Ekman, P., Friesen, W. V., & Hager, J. C. (2002). Facial action coding system (2nd ed.). Salt Lake City, UT: Research Nexus eBook.

- 3.Sowden, S., Schuster, B. A., Keating, C. T., Fraser, D. S., & Cook, J. L. (2021). The role of movement kinematics in facial emotion expression production and recognition. Emotion.

- 4.Perusquía-Hernández, M., Dollack, F., Tan, C. K., Namba, S., Ayabe-Kanamura, S., & Suzuki, K. (2020). Facial movement synergies and Action Unit detection from distal wearable Electromyography and Computer Vision. arXiv preprint. arXiv:2008.08791.

- 5.Miolla, A., Cardaioli, M., & Scarpazza, C. (2021). Padova Emotional Dataset of Facial Expressions (PEDFE): A unique dataset of genuine and posed emotional facial expressions. https://doi.org/10.31234/osf.io/t7dg3

- 6.Namba, S., Sato, W., Osumi, M., & Shimokawa, K. (2021). Assessing automated facial action unit detection systems for analyzing cross-domain facial expression databases. Sensors, 21(12), 4222.

PDFをダウンロード

1