- HOME

- 刊行物のご案内

- 心理学ワールド

- 98号 「正しさ」を考える

- DeepLabCutを用いたウマ・ゾウの行動解析

こころの測り方

DeepLabCutを用いたウマ・ゾウの行動解析

今野 愛紀(こんの あき)

Profile─今野 愛紀

専修大学大学院文学研究科心理学専攻修士課程修了。修士(心理学)。会社員。

加藤 大貴(かとう ひろき)

Profile─加藤 大貴

専修大学大学院文学研究科心理学専攻修士課程修了。修士(心理学)。自治体職員。

ヒトや動物の行動を研究する際に,その構造を定量的に抽出できるツールがあると便利です。今回は,ヒトや動物の運動を簡単にトラッキングできるDeepLabCutについて紹介します。

DeepLabCutとは

DeepLabCutとは,マティスらの研究チームが開発した[1],ディープニューラルネットワークを用いてヒトや動物の体の部位をラベル付けし,トラッキングしてくれる無料で使用可能な動画解析ライブラリです。高度な動作解析をGUI操作で手軽に行えることが大きな特徴です。

これまでの測定法は身体にマーカーを装着する方法が用いられ,録画した動画を見て観察者が行動を追跡したり,モーションキャプチャのための機材を利用したりする必要がありました。しかし,対象種によってはマーカーを装着することが困難な場合もあります。

DeepLabCutはPythonで動かすことができ,画像上でトラッキング用の目印をつけることができます。ほぼすべての作業がGUI上で可能なため,高度なプログラミングスキルは不要で,事前にトラッキング対象にマーカーをつける必要もありません。さらに,行程を繰り返すことでトラッキングの精度を上げることができます。解析後は時系列化された座標データがフレームごとに出力されるため,データハンドリングが容易で,細かい動的な情報の検討も可能になります。これは手動で動画を解析していては取得が難しいという点で,DeepLabCutを使用する大きなメリットといえます。

ウマがどちらの目で刺激を見ているか

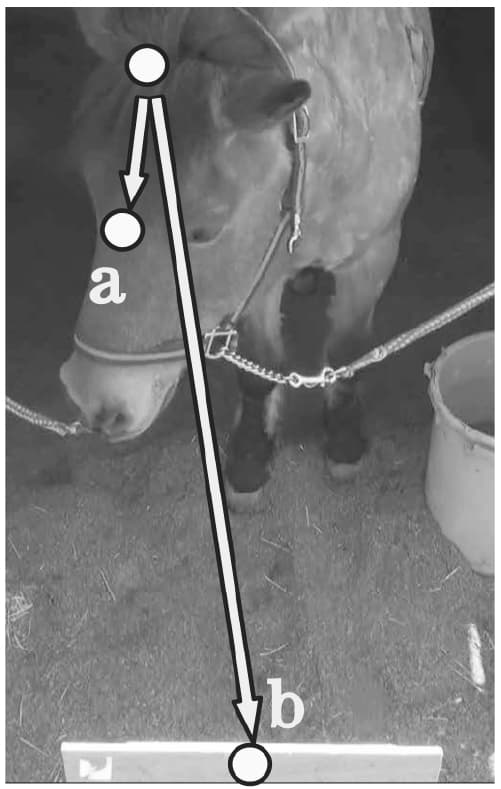

さて,ここからは,DeepLabCutの実用例として筆者らが実際に行った実験の解析を紹介します。図1は解析に使用した動画中のフレームの1枚で,ウマに対してヒトの表情の画像を呈示しています。ウマはネガティブな刺激に対して左目を用いることが知られています[2]。そのため,ウマが刺激に対してどちらの目を用いているか解析することで,その刺激に対してどのような認知をしているかについて調べることができます。

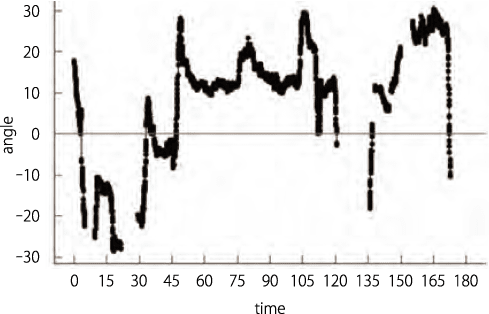

諸説ありますが,ウマの両眼視野は約60°といわれています[3]。したがって,刺激に対してウマの顔がどの程度傾いているかが分かれば,左側に30°以上の位置に振れた場合には右目を向けているといった具合に,ウマが刺激に対してどちらの目を向けているかを判断することができます。具体的な解析方法としては,DeepLabCutを用いてウマの頭,眉間および呈示中の刺激の上部の計3か所にマーカーを打ち,トラッキングを行います。トラッキング後,抽出された3点の座標データについて,ウマの頭に打った点の座標を基準としてウマの眉間の点のベクトル(a)と刺激に打った点のベクトル(b)をそれぞれ時点ごとに算出します。この算出した2つのベクトル間の内積を求めることで,図2に示すように各時点ごとにウマの顔が刺激に対して何度の位置にあるか解析することができます。

0°が刺激に対して正面を向いていることを,正の値が左へ,負の値が右へウマの顔が振れていることを示す。

これまでは,動物の行動観察の多くの場面において,直接人間が動画を見て行動にラベリングをする必要がありました。加えて,複数の観察者による観測結果を照合し,ラベリングされたデータの一致率を確認するといった手続きを用いることが多かったかと思います。しかし,DeepLabCutを用いれば,データ取得に要する労力と評価のバイアスを軽減することができます。

ゾウの鼻の運動解析

続いて,ゾウの鼻の動きについて定量的に解析した一例として,採餌運動時の動画解析について取り上げます。まずは,ゾウが餌を食べている動画を撮影し,教師用データとして,図3のようにゾウの鼻に10か所のマーカーをつけ,DeepLabCutを用いて座標データを抽出しました。ここで10点の移動の軌跡が得られますが,このままでは情報が多く解析が困難です。そのため,10点間の距離を総当たりで算出して,合計45次元の距離データに変換し,特徴的な成分を抽出するために主成分分析を行いました。

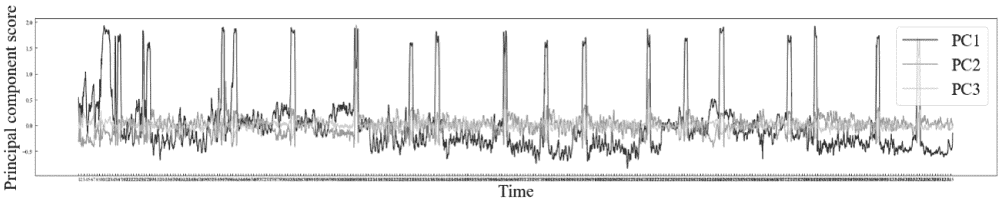

図4は第1主成分(PC1)から第3主成分(PC3)の主成分得点の時系列推移です。主成分の寄与率はPC1が0.837でしたので,PC1によって情報のほとんどが説明されそうだと判断できます。主成分分析を行った後は,動画と照らし合わせながら,各主成分がどのような動きの特徴を反映しているか確認します。今回の場合,餌を口に入れるときや,餌を掴むときの鼻の巻き・伸ばしの動作をPC1が説明していると考えられました。つまり,鼻に打った点間の距離が長いか短いかということが大きく反映されています。しかし,同じ点間の距離でも様々な鼻の向きや曲がり方,方向などが存在するため,“同じ距離だが違う姿勢”についても考慮する必要があります。これは二次元データの限界点ですが,DeepLabCutはそのような課題についても解決策を用意しており,複数のアングルからカメラを設置することで三次元での解析も可能です。

個々の分析方法の詳細は割愛しますが,点間の距離の分析だけではなく,各時点におけるゾウの姿勢で次元削減を行いクラスタリングすることで行動を自動分類することも可能です。また,動的時間伸縮法(Dynamic Time Warping)によって時系列データに対する類似度の測定や,クラスタ間の遷移確率,生起率の比較を行うこともできます。このように,ゾウのような実験的介入が困難な動物においても,抽出した座標データに基づき,幅広い分析が可能です。

今回は,ヒトや動物の行動を定量的に解析するためのツールとして,DeepLabCutを紹介しました。必要となるPCのスペックや,ソフトウエアのバージョンについては文献や公式サイト[4]を,またデモコードはGitHub[5]を参照してください。行動解析の手法に悩んでいる方はぜひ一度DeepLabCutに触れてみてください。

文献・注

- 1.Mathis, A., Mamidanna, P., Cury, K. M., Abe, T., Murthy, V. N., Mathis, M. W., & Bethge, M. (2018) DeepLabCut: Markerless pose estimation of user–defined body parts with deep learning. Nature Neuroscience, 21, 1281–1289.

- 2.Leliveld, L. M., Langbein, J., & Puppe, B. (2013) The emergence of emotional lateralization: Evidence in non-human vertebrates and implications for farm animals. Applied Animal Behaviour Science, 145(1–2), 1–14.

- 3.Waring, G. H. (2003) Horse behavior (pp.456–456). Noyes Publications.

- 4.http://www.mackenziemathislab.org/deeplabcut

- 5.https://github.com/DeepLabCut/DeepLabCut

PDFをダウンロード

1